-

Euro poco mosso, scambiato a 1,1552 dollari

Euro poco mosso, scambiato a 1,1552 dollari

-

L'Indonesia nomina l'ex presidente Suharto 'eroe nazionale'

-

Scontri in carcere in Ecuador, almeno 31 morti

Scontri in carcere in Ecuador, almeno 31 morti

-

'Raggiunto l'accordo per mettere fine allo shutdown'

-

Sarri, è ora di pensare a noleggiare arbitri dall'estero

Sarri, è ora di pensare a noleggiare arbitri dall'estero

-

Atalanta; ore decisive per Juric, Palladino pronto

-

Serie A: Inter-Lazio 2-0, nerazzurri in testa con la Roma

Serie A: Inter-Lazio 2-0, nerazzurri in testa con la Roma

-

Trump attacca i vertici della Bbc, 'giornalisti corrotti'

-

F1: Brasile;Leclerc e suo ritiro 'sono inc... Piastri ottimista'

F1: Brasile;Leclerc e suo ritiro 'sono inc... Piastri ottimista'

-

Roma, problema al quadricipite per Dovbyk

-

Media, 'Senato Usa vicino ad accordo per fine shutdown'

Media, 'Senato Usa vicino ad accordo per fine shutdown'

-

Calcio: il City asfalta il Liverpool e va a -4 dall'Arsenal

-

Finals: Bolelli/Vavassori 'match giocato in nostra top 5'

Finals: Bolelli/Vavassori 'match giocato in nostra top 5'

-

Gasperini 'primato motivo orgoglio, giusto tifosi Roma sognino'

-

Mondiali: Kean salta Moldavia e Norvegia, al suo posto Cambiaghi

Mondiali: Kean salta Moldavia e Norvegia, al suo posto Cambiaghi

-

Oltre 1.600 voli cancellati oggi negli Usa per lo shutdown

-

Genoa: De Rossi 'abbiamo lottato con i denti, ripartiamo da qui'

Genoa: De Rossi 'abbiamo lottato con i denti, ripartiamo da qui'

-

F1: Brasile; vince McLaren Norris, 2/a Mercedes Antonelli

-

Finals: doppio, Bolelli/Vavassori show contro i n.1 al mondo

Finals: doppio, Bolelli/Vavassori show contro i n.1 al mondo

-

Paradiso, 'anche il ricordo della scuola con me sul palco'

-

Conte deluso 'non posso fare un trapianto di cuore alla squadra'

Conte deluso 'non posso fare un trapianto di cuore alla squadra'

-

F1:Brasile; contatto con Antonelli, Ferrari Leclerc subito fuori

-

Esn arriva in Italia, integrazione sportiva debutta a Milano

Esn arriva in Italia, integrazione sportiva debutta a Milano

-

Segretario Trasporti Usa, 'il traffico aereo si ridurrà a zero'

-

Kiev, in 100.000 senza luce e gas nel Kharkiv per raid russi

Kiev, in 100.000 senza luce e gas nel Kharkiv per raid russi

-

Sanchez, porterò a termine legislatura e mi ricandiderò nel '27

-

'Mezzogiorno', con lo chef Mazzei nuovo angolo d'Italia a Londra

'Mezzogiorno', con lo chef Mazzei nuovo angolo d'Italia a Londra

-

Finals: Alcaraz 'primo incontro mai facile, sono contento'

-

Fieracavalli chiude con oltre 140mila visitatori

Fieracavalli chiude con oltre 140mila visitatori

-

Serie A: il Bologna batte 2-0 il Napoli, Genoa-Fiorentina 2-2

-

Finals: Auger-Aliassime 'stimolante iniziare contro Sinner'

Finals: Auger-Aliassime 'stimolante iniziare contro Sinner'

-

Juric 'Atalanta non all'altezza, responsabilità è del tecnico'

-

Francobollo per 160 anni del Sole 24 Ore, 'dedicato ai lettori'

Francobollo per 160 anni del Sole 24 Ore, 'dedicato ai lettori'

-

All'esordio Alcaraz soffre ma supera De Minaur

-

Sassuolo: Grosso, livello si è alzato ma noi anche fortunati

Sassuolo: Grosso, livello si è alzato ma noi anche fortunati

-

Modenese morto in Algeria, società dell'hotel condannata

-

A Tommy Mauri la settima edizione di ProSceniUm

A Tommy Mauri la settima edizione di ProSceniUm

-

Gp Brasile: Verstappen cambia motore, partirà dalla pit lane

-

Cyndi Lauper, Outkast, White Stripes nella Rock Hall of Fame

Cyndi Lauper, Outkast, White Stripes nella Rock Hall of Fame

-

Taekwondo: conclusi Assoluti, assegnati ultimi titoli a Messina

-

MotoGp: Bezzecchi "gara fantastica, vittoria davvero goduta"

MotoGp: Bezzecchi "gara fantastica, vittoria davvero goduta"

-

Axios,5 miliardi di armi Usa per Kiev bloccate da shutdown

-

Wicked - Parte 2, tornano in sala le streghe di Oz

Wicked - Parte 2, tornano in sala le streghe di Oz

-

'With Hasan in Gaza' vince al Festival dei Popoli

-

MotoGp: Bezzecchi vince in Portogallo, caduta per Bagnaia

MotoGp: Bezzecchi vince in Portogallo, caduta per Bagnaia

-

Serie A: Atalanta-Sassuolo 0-3

-

Finals: esordio vincente nel doppio per Granollers-Zeballos

Finals: esordio vincente nel doppio per Granollers-Zeballos

-

Giorgetti, 'su manovra massacrati da chi può farlo'

-

Scala, Chailly 'Lady Macbeth Šostakovič opera straordinaria'

Scala, Chailly 'Lady Macbeth Šostakovič opera straordinaria'

-

Moto: Morerira vince a Portimao, titolo Moto2 a un passo

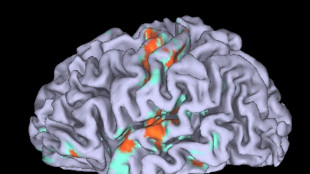

Uno studio esplora come rendere l'IA meno energivora

Pubblicazione su Jstat indaga efficacia del curriculum learning

Più biglietti della lotteria compri, maggiori sono le probabilità di vincere, ma spendere più di quanto guadagni non è una strategia saggia: qualcosa di simile accade nell'IA basata sul deep learning: più grande è una rete neurale, meglio può apprendere il compito assegnato. Purtroppo però rendere una rete infinitamente grande durante l'addestramento è impossibile e inefficiente. I cervelli biologici apprendono attraverso un processo parco nell'uso delle risorse che si è provato a imitare fornendo alle macchine un addestramento graduale, che parte da esempi semplici e progredisce verso quelli complessi (curriculum learning): una strategia sensata ma irrilevante per le reti molto grandi. Lo studio pubblicato sul Journal of Statistical Mechanics: Theory and Experiment (Jstat), uno dei giornali della Sissa/Iop, ha cercato di capire il perché di questo fallimento, suggerendo che queste reti sovraparametrizzate sono talmente ricche da sfruttare spontaneamente un percorso di apprendimento basato più sulla quantità di risorse che sulla loro qualità. Questa osservazione suggerisce che, regolando la dimensione iniziale della rete, il curriculum learning potrebbe rivelarsi una strategia valida, da sfruttare per creare reti neurali meno energeticamente dispendiose. "Ciò che abbiamo osservato è che una rete neurale sopra parametrizzata non ha bisogno di un percorso di apprendimento, perché, invece di essere guidata dagli esempi, è guidata dal fatto che dispone già di tante risorse—parametri che per caso si trovano già vicini a una soluzione, che vengono imboccati spontaneamente", osserva Luca Saglietti, fisico dell'Università Bocconi di Milano, che ha coordinato lo studio. Questo non significa che le reti non possano beneficiare del curriculum learning, ma che, data l'alta quantità di parametri iniziali, sono spinte in una direzione diversa. In teoria quindi si potrebbe trovare un modo per iniziare con reti più piccole e adottare il curriculum learning. "Questa è una parte dell'ipotesi esplorata nel nostro studio", rileva Saglietti. "Almeno negli esperimenti che abbiamo condotto, abbiamo osservato che, iniziando con reti più piccole, l'effetto del curriculum inizia a migliorare le prestazioni rispetto a quando l'input viene fornito casualmente. Questo miglioramento è maggiore rispetto a quando si continua ad aumentare i parametri fino al punto in cui l'ordine degli input non importa più".

F.Schneider--AMWN