-

Indonesia, 16 morti nell'incendio di una casa di riposo

Indonesia, 16 morti nell'incendio di una casa di riposo

-

Macron, a gennaio incontro dei Volenterosi a Parigi per gli aiuti all'Ucraina

-

Atalanta: Palladino 'peccato, ma non condanno errori individuali'

Atalanta: Palladino 'peccato, ma non condanno errori individuali'

-

Chivu 'vittoria importante, quello che dice Conte non mi interessa'

-

Zelensky, 'Donbass è una questione difficile, con Mosca posizioni diverse'

Zelensky, 'Donbass è una questione difficile, con Mosca posizioni diverse'

-

Trump, 'se va bene, l'accordo in un paio di settimane'

-

Con l'Atalanta basta Lautaro, l'Inter chiude il 2025 in vetta

Con l'Atalanta basta Lautaro, l'Inter chiude il 2025 in vetta

-

Trump, 'Putin è molto serio, sia lui che Zelensky vogliono la pace'

-

Zelensky, 'con Trump parleremo della questione territoriale'

Zelensky, 'con Trump parleremo della questione territoriale'

-

Trump assicura, 'forti garanzie di sicurezza all'Ucraina, coinvolgeranno l'Europa'

-

Serie A: Bologna-Sassuolo 1-1

Serie A: Bologna-Sassuolo 1-1

-

Calcio: Globe Soccer Awards, Dembélé miglior giocatore e dominio Psg

-

Sabalenka 'lottato alla grande, contro un uomo il tennis è diverso'

Sabalenka 'lottato alla grande, contro un uomo il tennis è diverso'

-

Sci: Semmering; Shiffrin vince ancora, 15/a l'azzurra Peterlini

-

Sabalenka ko in due set, a Kyrgios la 'Battaglia dei sessi'

Sabalenka ko in due set, a Kyrgios la 'Battaglia dei sessi'

-

Continua la marcia di Zalone, in tre giorni oltre 20 milioni al box office

-

Conte soddisfatto, vincere a Cremona è molto difficile

Conte soddisfatto, vincere a Cremona è molto difficile

-

Lazio: il club chiede l'intervento della Lega A su errori arbitrali, invia Pec

-

Borgonzoni "auguri Capri, il successo di Zalone fa riflettere"

Borgonzoni "auguri Capri, il successo di Zalone fa riflettere"

-

L'Iran lancia 3 nuovi satelliti a bordo del vettore russo Soyuz

-

Il portavoce della centrale di Zaporizhzhia, 'l'impianto è stabile'

Il portavoce della centrale di Zaporizhzhia, 'l'impianto è stabile'

-

Zelensky, 'molte decisioni potrebbero essere prese entro fine anno'

-

Voto in Kosovo, il premier Kurti auspica una formazione del governo rapida

Voto in Kosovo, il premier Kurti auspica una formazione del governo rapida

-

Serie A: Cremonese-Napoli 0-2

-

Sci nordico: Tour de ski, dominio norvegese nella sprint a Dobbiaco

Sci nordico: Tour de ski, dominio norvegese nella sprint a Dobbiaco

-

Il Museo nazionale del cinema ricorda Brigitte Bardot

-

Rio svela il piano per il Capodanno, 13 palchi e fuochi d'artificio

Rio svela il piano per il Capodanno, 13 palchi e fuochi d'artificio

-

Il raro Stiffelio di Giuseppe Verdi in scena a Modena e Reggio Emilia

-

Cdm donne: Rast in testa allo slalom di Semmering, Della Mea 13/a

Cdm donne: Rast in testa allo slalom di Semmering, Della Mea 13/a

-

Bardot e la straziante storia della Renault 4L che non volle più guidare

-

Verona: Bertolini, fatto la gara che dovevamo ma col Milan serve perfezione

Verona: Bertolini, fatto la gara che dovevamo ma col Milan serve perfezione

-

Milan: Allegri, soddisfatto ma non bisogna abbassare l'asticella

-

Zelensky è arrivato in Florida per l'incontro con Trump

Zelensky è arrivato in Florida per l'incontro con Trump

-

Fresi, con i tagli ai fondi rischia di sparire il cinema più fragile e libero

-

Serie A: Milan-Verona 3-0

Serie A: Milan-Verona 3-0

-

Gasperini 'se Dybala sta bene, il valore della Roma aumenta'

-

Gasperini 'non credo molto al mercato di gennaio, conto sulla Roma di oggi'

Gasperini 'non credo molto al mercato di gennaio, conto sulla Roma di oggi'

-

Il guardaroba libero e sensuale di BB, dallo scollo alla Bardot al bikini

-

Biennale Venezia, BB ha messo in discussione gli stereotipi sulla donna

Biennale Venezia, BB ha messo in discussione gli stereotipi sulla donna

-

Il presidente colombiano riorganizza i vertici militari in vista del 2026

-

Capri omaggia Brigitte Bardot con 'Il Disprezzo' di Godard

Capri omaggia Brigitte Bardot con 'Il Disprezzo' di Godard

-

Morta Brigitte Bardot, due ricoveri poi la fine a 'La Madrague'

-

Vela: il maxi Comanche vince la Sydney-Hobart, battuto LawConnect

Vela: il maxi Comanche vince la Sydney-Hobart, battuto LawConnect

-

Nba; Antetokounmpo rientra dall'infortunio, Milwaukee sorride

-

Calcio: Pisa-Juventus 0-2

Calcio: Pisa-Juventus 0-2

-

Lavrov, 'il regime di Zelensky non è pronto per colloqui costruttivi'

-

Calcio: Lazio sugli arbitri 'errori a nostro sfavore, chiediamo rispetto e uniformità'

Calcio: Lazio sugli arbitri 'errori a nostro sfavore, chiediamo rispetto e uniformità'

-

Macron, 'raid su Kiev provano che Putin vuole prolungare la guerra'

-

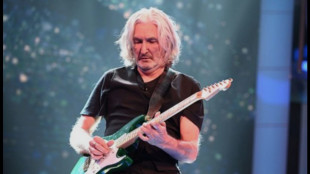

Palmer e Zurzolo, Sorrento Film & Food Festival premia la grande musica

Palmer e Zurzolo, Sorrento Film & Food Festival premia la grande musica

-

Tusk, 'europei uniti su Kiev, garanzie di sicurezza cruciali'

Le IA non sanno distinguere tra opinioni personali e i fatti

Studio, limitazione cruciale, rischio disinformazione

I grandi modelli linguistici di Intelligenza Artificiale come ChatGpt non sono affidabili quando si tratta di distinguere tra opinioni personali e fatti: una limitazione cruciale, vista la crescente diffusione di questi strumenti in ambiti chiave come la medicina, il diritto, il giornalismo e la scienza, nei quali è imperativa la capacità di distinguere la realtà dalla finzione. Lo afferma lo studio pubblicato sulla rivista Nature Machine Intelligence e guidato dall'Università americana di Stanford: evidenzia la necessità di essere cauti nell'affidarsi a questi programmi e il rischio che possano favorire la diffusione della disinformazione. I ricercatori coordinati da James Zou hanno messo alla prova 24 Large Language Model i cosiddetti Llm, tra cui ChatGpt della californiana OpenAI e il cinese DeepSeek, ponendo loro 13mila domande. Quando è stato chiesto di verificare dati fattuali veri o falsi, la precisione è risultata elevata pari a oltre il 91% per le versioni più nuove dei programmi. Passando alle credenze espresse in prima persona, invece, tutti i modelli testati hanno fallito: Gpt 4, la versione rilasciata a maggio 2024, ha visto scendere la sua affidabilità dal 98,2% al 64,4%, mentre la versione R1 di DeepSeek è precipitata addirittura da oltre il 90% al 14,4%. La riduzione dell'accuratezza è stata meno marcata per le opinioni espresse in terza persona e ciò, secondo gli autori dello studio, rivela un preoccupante bias di attribuzione, cioè una distorsione nel modo in cui vengono valutate le affermazioni fatte da altri. Inoltre, gli Llm risultano meno propensi a riconoscere una credenza falsa rispetto ad una vera: più precisamente, il 34,3% meno propensi per gli ultimi modelli. I ricercatori affermano, dunque, che miglioramenti in questo ambito sono urgentemente necessari se si vuole prevenire la diffusione di fake news.

J.Williams--AMWN